Maandag – mijn favoriete dag om nieuwe dingen te leren! Zoals u weet draait dit kwartaal alles om het ontwikkelen van een datastrategie. Klanten vragen wel eens: “kun jij in één keer een datastrategie voor ons bouwen.” Het simpele antwoord is: “nee.” Het uitgebreidere antwoord zou zijn: bij het bouwen van een datastrategie zijn veel bewegende delen betrokken. Elke maandag van dit kwartaal gaan we in op een van deze bewegende delen. Kunnen we aan elk van deze aspecten werken en – in de loop van meerdere maanden – een datastrategie voor u ontwikkelen? Zeker! In dit bericht zal ik ingaan op de kwestie van de gegevenskwaliteit (DQ).

‘Weet je wat statistici altijd zeggen? Vuilnis erin, afval eruit.”

Laten we opnieuw beginnen met het ‘waarom’. Waarom lossen we dataproblemen op? Welnu, omdat het bedrijf zonder fatsoenlijke gegevens inkomsten zal verliezen (stel je een aanbevelingsmotor voor op een e-commercewebsite die zijn publiek verkeerde dingen aanbeveelt) en zal lijden onder slechte besluitvorming (wat op zijn beurt inkomstenverlies betekent, toch?).

Met welke problemen op het gebied van de datakwaliteit kun je te maken krijgen? Hier is een lijst met de meest voorkomende problemen (ik begin met de problemen die onder PEBCAK vallen – als je dit acroniem niet kent, zoek het dan op😸):

- Ongeldige gegevens: stel je voor dat mensen foutieve gegevens invoeren in een systeem, wat bijvoorbeeld resulteert in negatieve voorraadniveaus.

- Inconsistente formaten: wanneer mensen wordt gevraagd de datum te noteren, vind je allerlei variaties (bijvoorbeeld: 2 november 2022, 02/11/2022, 11/02/2022, 11/02/22).

- Onnauwkeurige gegevens (voor verkoopteams: leden die geen “CRM-hygiëne” toepassen)

- Dubbele gegevens (kan het gevolg zijn van een menselijke of systeemfout)

- Onvolledige informatie (bijvoorbeeld: het weglaten van middelste namen bij het doornemen van een geboorteregister – kan ertoe leiden dat u de juiste persoon niet kunt vinden)

- Gegevensinconsistentie (metrische versus imperiale systemen zijn de meest voor de hand liggende)

- Onnauwkeurige gegevens (kan te wijten zijn aan ETL-processen of statistische keuzes: het groeperen van gegevens maakt deze bijvoorbeeld “minder nauwkeurig”).

Hoe los je deze problemen op, vraag je je misschien af? Als je hoopte op een ‘snelle oplossing’, zul je teleurgesteld zijn. Er zijn drie hoofdstrategieën:

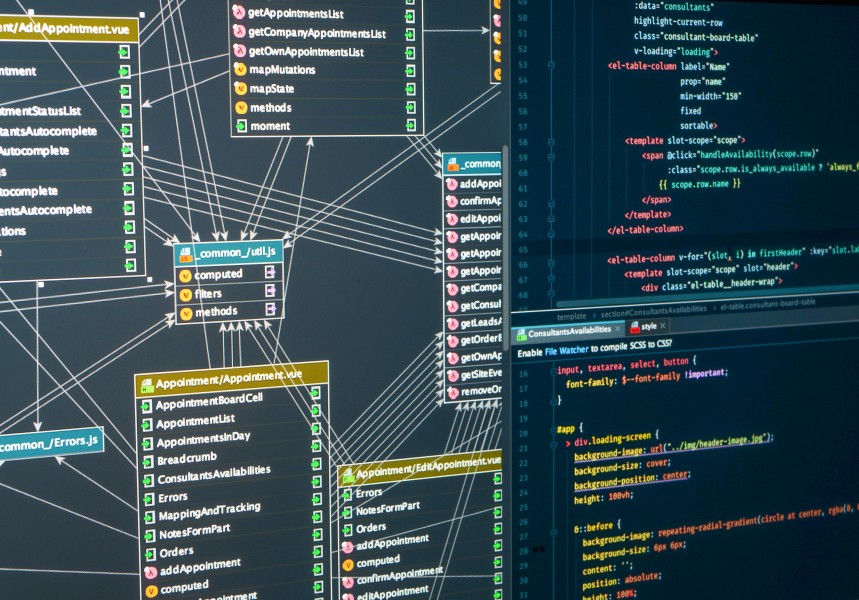

- Los de problemen in de bronsystemen op

- Oplossing tijdens het ETL-proces

- Oplossing op metadataniveau (dit is niet echt een oplossing, het lijkt meer op patchen omdat de kerngegevens onaangeroerd blijven)

Tot op zekere hoogte heeft kunstmatige intelligentie een aantal van deze problemen al opgelost. De mogelijkheid om formaten automatisch aan te passen op basis van locatie (bijvoorbeeld: als gegevens op Amerikaans grondgebied zijn ingevoerd, is het waarschijnlijk dat ze het imperiale systeem hebben gebruikt) is daar een voorbeeld van. “Zelfherstellende” datapijplijnen zijn een ander voorbeeld dat het vermelden waard is. Zonder al te veel in detail te treden: datakwaliteit is de belangrijkste belemmering geweest voor organisaties die hun data willen benutten. Hoewel AI een helpende hand lijkt te bieden, willen organisaties nog steeds op de hoogte zijn van:

- Het creëren van sterke datafundamenten

- Definieer welke gegevens voor welke KPI kunnen dienen

- Wijs de verantwoordelijkheid voor de datakwaliteit toe aan BU’s (business units) naast een CDO

- Veranker de verbetering van de datakwaliteit in de organisatiecultuur

Als u aan de slag wilt, neem dan gerust contact op.